Les entreprises extraient la data de plusieurs sources internes et externes et engagent des analystes, les data scientists pour les aider à générer des informations exploitables. Toutefois, l'un des principaux problèmes rencontrés est l'ampleur de la collecte de données.

Une entreprise de taille importante peut générer des milliers de gigaoctets de données en quelques mois pour des études de marché et le suivi des tendances. À partir d'un certain point, il n'est ni réaliste ni prudent de collecter et de rassembler ces données manuellement. C'est là que des techniques comme le web scraping peuvent être utiles.

Les outils de scraping web peuvent aider les analystes à étudier un grand nombre de sites web. Ces outils collectent des données à partir de sites pertinents et les convertissent dans un format structuré, ce qui facilite leur compréhension.

Cet article passe en revue certaines caractéristiques de base que vous devriez retrouver dans les outils de scraping Web. Nous inclurons également nos recommandations pour les meilleurs outils de scraping Web en 2022. Ces outils ont pu être utilisés avec Linux, Windows ou macOS.

Voici quelques éléments à prendre en compte lors du choix d'un outil de scraping web.

Scalabilité

Les besoins de l'entreprise évoluent au fil du temps, et il en va de même pour vos capacités de web scraping. À mesure que votre entreprise se développe, vous devrez recueillir et analyser davantage de données provenant de plus en plus de sources. Votre outil de web scraping doit être en mesure de répondre à ces besoins exponentiels et d'explorer efficacement les sites Web, même pour les grands ensembles de données.

Bien que réalistement chaque outil soit censé ralentir un peu lorsqu'il traite un volume de données extrêmement élevé, vous devez vous assurer que l'outil peut encore fonctionner suffisamment bien pour vos besoins.

Une tarification transparente

Un modèle de tarification clair s'applique à tous les outils commerciaux que vous recherchez sur Internet. Tout fournisseur d'outils de scraping Web que vous choisissez doit être transparent quant à sa tarification et aux services inclus dans la formule.

Par exemple, si un site ne mentionne pas les frais supplémentaires (en plus du prix de l'abonnement) pour opérer sur des moteurs de recherche difficiles à scraper comme Google ou des sites d'e-commerce comme Shopify et Amazon, cela doit être un signal d'alarme. Bien qu'il ne soit pas rare que les packages de web scraping avancés coûtent plus cher, la plupart des prix devraient être indiqués sur le site Web (ou vous devriez avoir une autre occasion de vérifier les tarifs avant de faire l'achat).

Restitution des données

Votre choix d'outil de web scraping devrait également dépendre des formats dans lesquels les résultats seront livrés. Les outils de web scraping rassemblent les données collectées dans des formats structurés ou semi-structurés. Si ces données ne sont pas présentées dans le bon format, vous risquez de ne pas pouvoir les utiliser avec les outils de Business Intelligence (BI) comme Power BI de Microsoft ou même Excel.

Idéalement, un outil de scraping web devrait vous donner la possibilité de télécharger les données collectées dans un large éventail de formats standard (par exemple, XML, JSON et CSV). L'outil devrait aussi être en mesure de vous livrer les résultats directement via FTP, Google Cloud Storage (Google Drive), DropBox ou un autre service de stockage sur le cloud.

API Proxy

Les proxys API aident à être plus efficaces en donnant accès à des sites qui ne sont peut-être pas disponibles dans votre région. Comme le terme l'indique, les API proxy permettent de masquer l'identité de votre outil ou sa provenance d’origine pendant qu'il explore les pages Web. En quoi cela est-il utile ? De nombreux sites Web emploient des mesures anti-scraping.

Les proxys API créent plusieurs identités d'utilisateurs, ce qui donne au trafic une apparence plus ordinaire. De plus, les proxies agissent pareillement comme une couche de protection supplémentaire entre vos appareils et les sites Web malveillants. Cependant, l’efficacité n’est pas garantie, c'est pourquoi il est préférable d’utiliser conjointement des outils anti-malware pour protéger vos appareils.

Nos meilleurs choix d'outils de scraping Web

Maintenant que nous connaissons certaines des caractéristiques les plus importantes pour la sélection de vos outils de scraping Web, découvrez nos meilleurs choix.

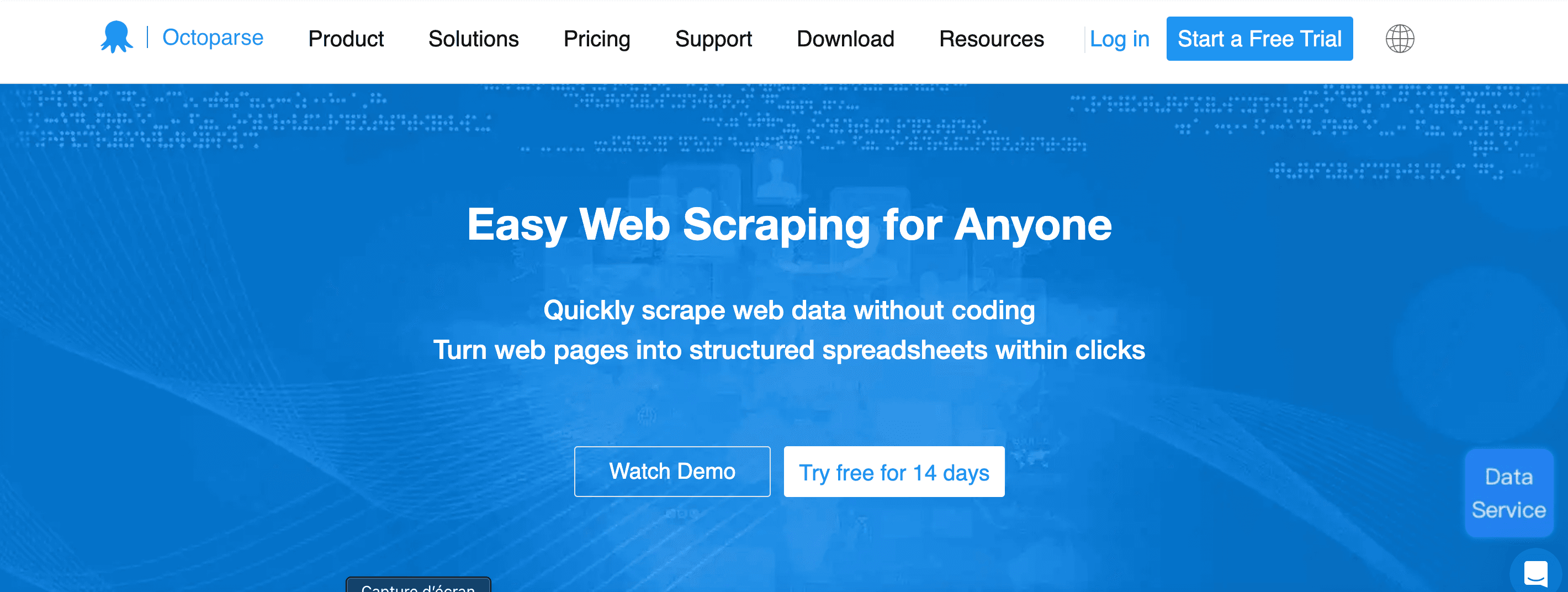

Octoparse

Octoparse est un outil de scraping facile à utiliser, commercialisé par Octopus Data, Inc. à Walnut, en Californie. L'outil offre des fonctionnalités avancées de scraping telles que l'extraction de données multiformat (qui prend en charge les formats CSV, Excel et API), la rotation des adresses IP et le scraping de données programmé.

Scalabilité : Faible

Une tarification transparente : Oui

Restitution des données : À la demande, multiformat (Excel, CSV, HTML, JSON, ou votre base de données)

API Proxy : Oui

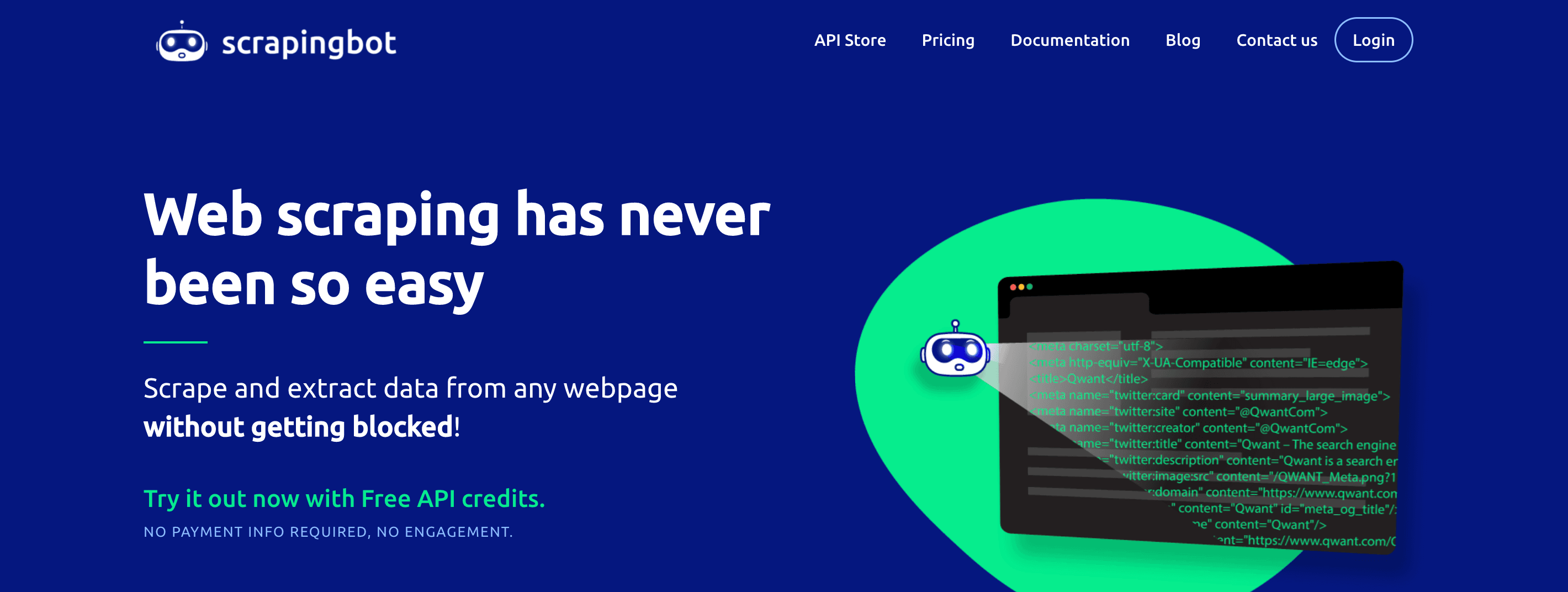

ScrapingBot

ScrapingBot est une solution puissante de scraping fournie par une société technologique française du même nom. Contrairement à certains de nos autres choix, ScrapingBot est une API de scraping qui peut s'intégrer à d'autres outils et plateformes.

Scalabilité : Élevé

Une tarification transparente : Oui

Restitution des données : A la demande, multi-format (TXT, HTML CSV, ou Excel)

API Proxy : Oui

ParseHub

ParseHub a été développé et commercialisé par une société située à Toronto. ParseHub est proposé à un prix correspondant à sa vitesse et à son efficacité en matière de scraping, ce qui permet aux entreprises d'utiliser l'outil à une vitesse réduite, gratuitement et indéfiniment. Le plan gratuit permet aux utilisateurs de conserver les données de cinq projets publics pendant un maximum de 14 jours.

Scalabilité : Élevé

Une tarification transparente : Oui

Restitution des données : A la demande, multi-format (AJAX, couverture de type drop-down, CSV, JSON)

API Proxy : Oui

Le Web scraping n'est pas aussi facile qu'il n'y paraît, surtout lorsque vous avez des besoins en données extrêmement spécifiques. Pour la plupart des projets, les entreprises n'ont besoin que d'un certain type de données provenant de sites Web pertinents. Cela nécessite généralement un outil de scraping ou un extracteur personnalisé et des data analystes dédiés qui surveillent de près les processus d'extraction.

Avec LeGratin.io, vous pouvez trouver les bons growth hacker en freelance pour votre prochain projet. Les indépendants de notre communauté ont l'expérience et les certifications nécessaires pour vous aider à démarrer votre projet et à le maintenir à flot.

Si vous êtes un indépendant à la recherche d'une mission freelance en growth hacking, rejoignez la communauté dès aujourd'hui.